使用CherryStudio、Ollama、腾讯云搭建本地个人知识库、智能体

需要部署大模型和嵌入模型(太要求电脑配置了,配置差的最好不要尝试,我i5,16G内存,固态硬盘,集成显卡,deepseek根本跑不起来,llama3勉强能跑起来,但是超级慢,嵌入模型nomic-embed-text:latest跑起来后,向量化个几k的文本文件用了几分钟)安装ollama启动ollama启动后,Ollama会在默认端口11434上运行。你可以通过浏览器访问拉取llama3模型运行模

1、准备大模型

(1)准备使用ollama部署的本地大模型的地址默认是http://localhost:11434

需要部署大模型和嵌入模型(太要求电脑配置了,配置差的最好不要尝试,我i5,16G内存,固态硬盘,集成显卡,deepseek根本跑不起来,llama3勉强能跑起来,但是超级慢,嵌入模型nomic-embed-text:latest跑起来后,向量化个几k的文本文件用了几分钟)

下载ollama:https://ollama.com/download

安装ollama

启动ollama

ollama start启动后,Ollama会在默认端口11434上运行。你可以通过浏览器访问http://localhost:11434

拉取llama3模型

ollama pull llama3运行模型

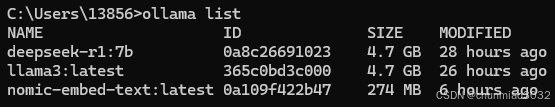

ollama run llama3查看模型

ollama list再拉取嵌入模型

ollama pull nomic-embed-text然后运行

查看拉取的模型

(2)或者准备部署在公有云上的大模型地址和api_key,嵌入模型使用CherryStudio提供的

打开这个网页:https://console.cloud.tencent.com/lkeap(目前可以免费试用一段时间,不需要花钱)

注册、登录后,勾选我已阅读并同意,点击开通大模型知识引擎

然后可以选择立即使用或者进入控制台

选择立即使用就是可以直接使用腾讯的网页版大模型知识引擎

地址:https://lke.cloud.tencent.com/lke#/experience-center/home?origin=all

要调用API,选择进入控制台

第一步、获取API密钥

点击立即接入

点击下面的使用 OpenAI SDK 方式接入里的创建API KEY

(3)或到官网充值后申请的api_key

我没用这种方式(不想花钱)

2、Cherry官网下载CherryStudio,并安装

Cherry Studio

打开网站:https://cherry-ai.com/

点击下载客户端

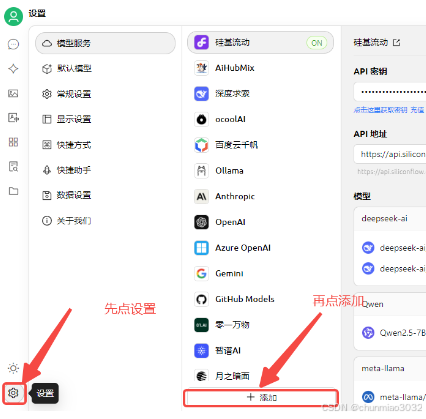

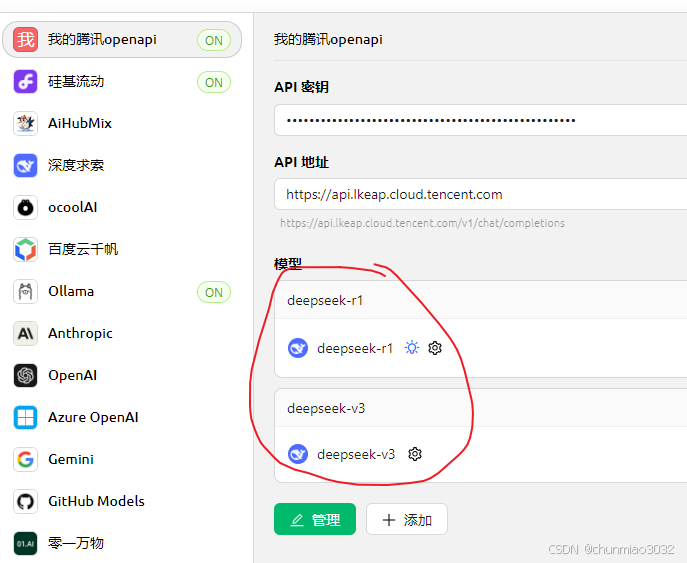

3、配置CherryStudio,添加腾讯云上创建的大模型

填写提供商名称(随便你取名,只要你自己能区分出来就行)

提供商类型不要变,就默认的OpenAI

点确定

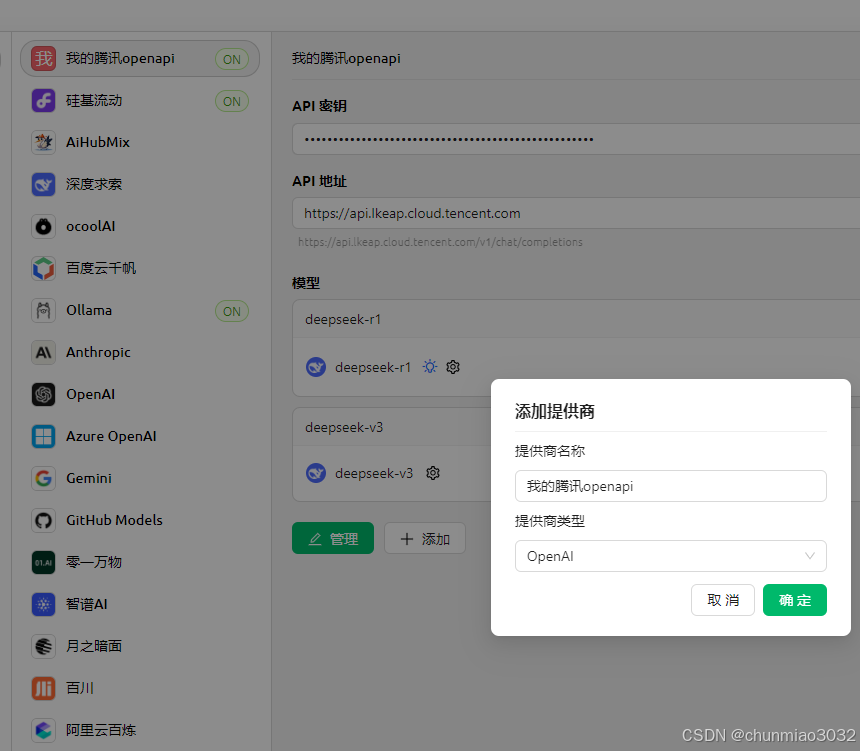

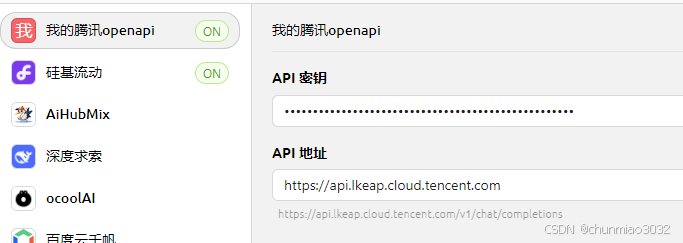

然后把前边复制的API密钥填写进去

API地址是:https://api.lkeap.cloud.tencent.com

然后再点击添加

分别添加deepseek-r1和deepseek-v3模型

(当然你如果不用v3,可以只添加r1)

填入模型ID(deepseek-r1或deepseek-v3),点击添加模型

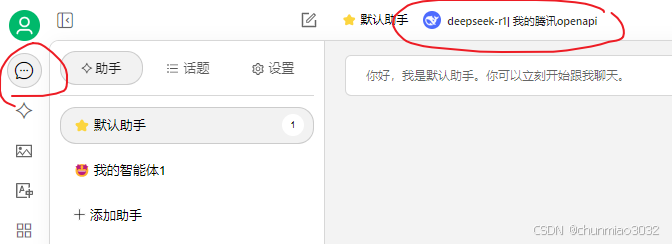

选择聊天,选择配置的大模型,就可以对话了

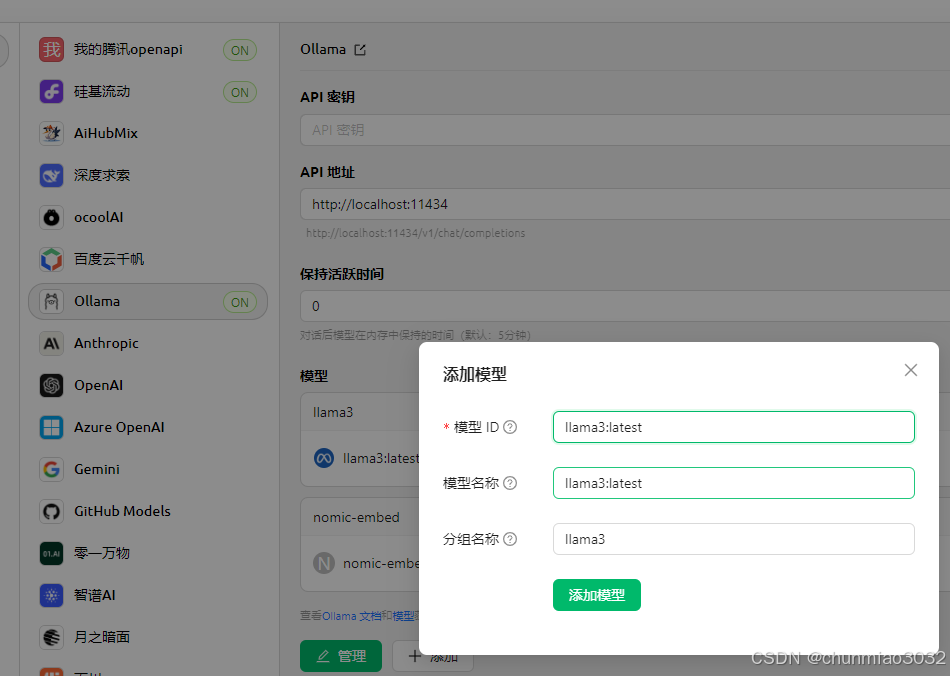

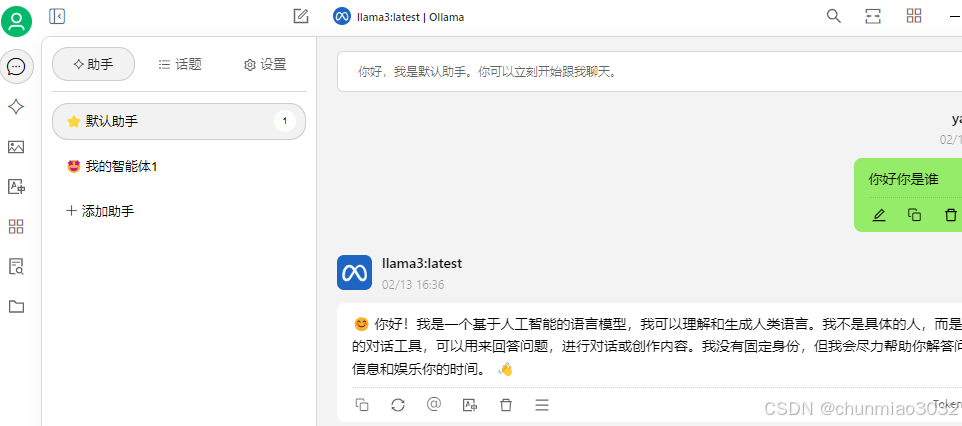

4、配置CherryStudio,本地安装的ollama大模型

分别添加llama3、和嵌入模型nomic-embed-text:latest

由于是本地部署,不需要填写api秘钥,api地址填写ollama的默认端口就行

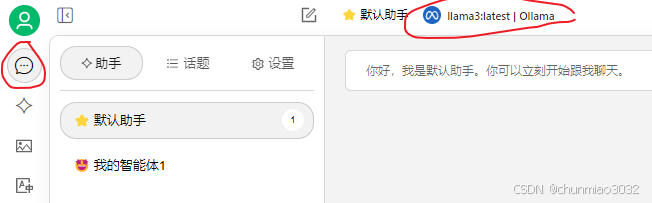

选择ollama中的大模型

可以通过本地大模型进行对话(就是超级慢)

5、配置知识库

设置里,点选中这个模型,直接点“获取”就可以获取嵌入模型的到api秘钥

知识库,添加知识库,选择嵌入模型

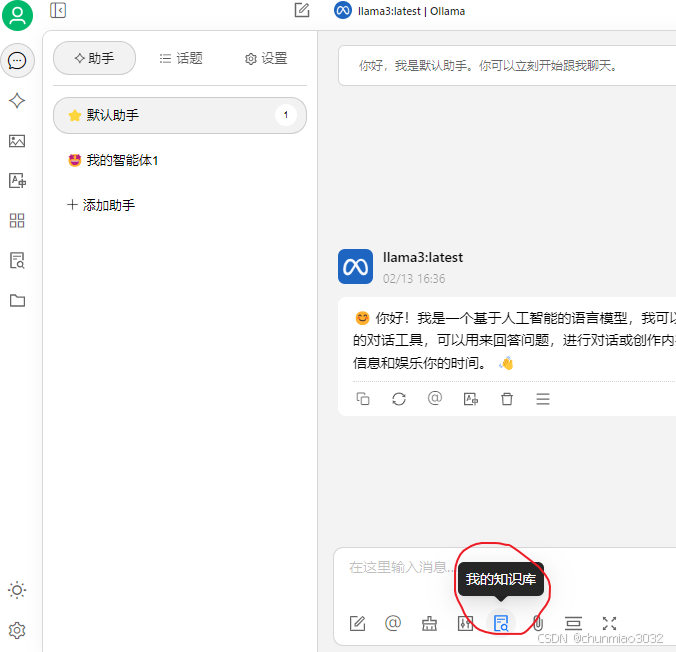

点知识库,拖拽文件到这里,然后自动进行向量化

等向量化结束后,后面会变绿色对号

然后可以到提问窗口选择使用的知识库

然后会从知识库中检索内容,最后合成回答

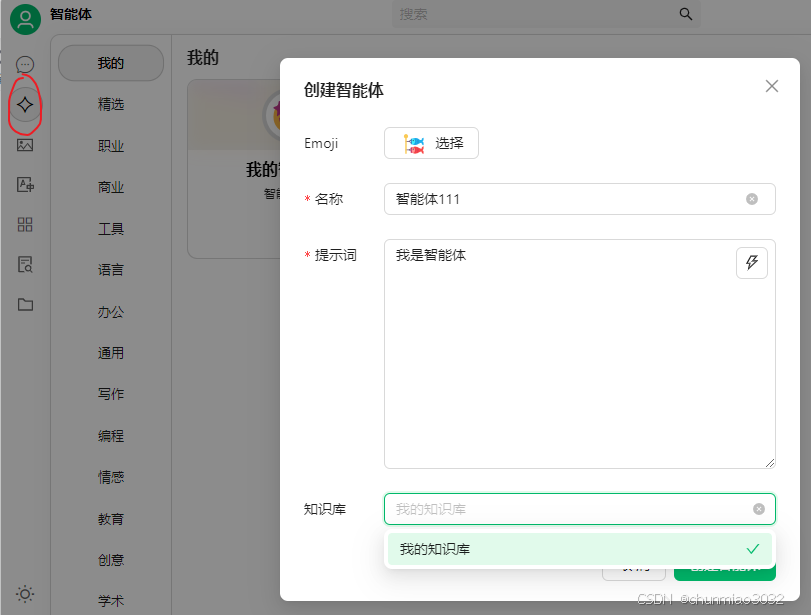

6、配置智能体

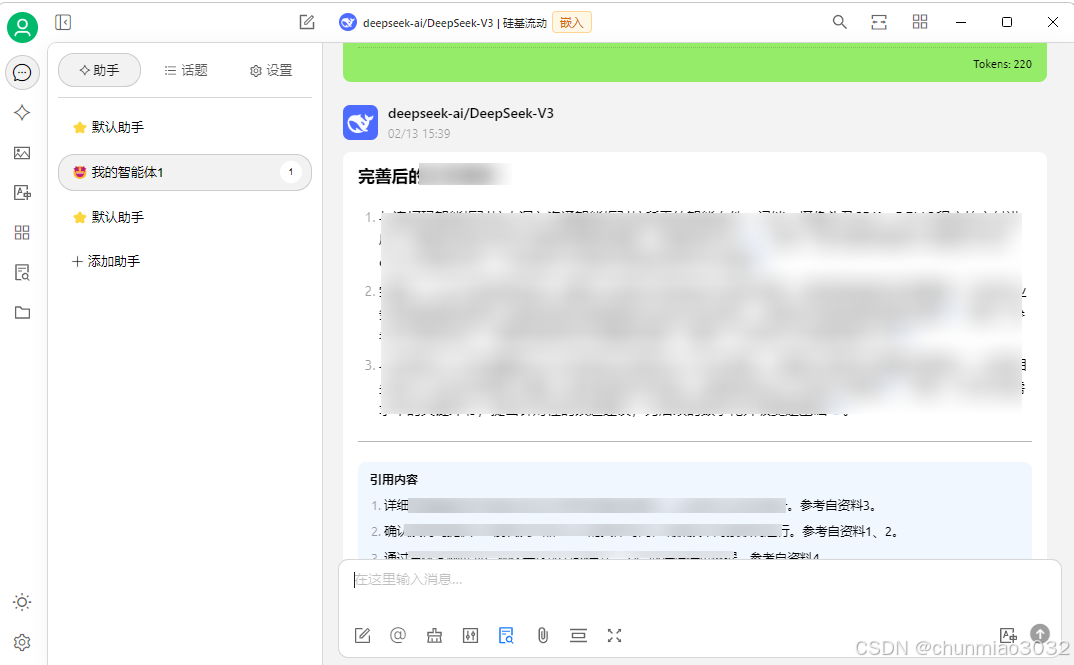

选择引用的知识库创建智能体

使用智能体

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)