纯法律人从0学AI记录(6)- 跟着大佬部署好了本地免费大模型!

教会小白2h部署好本地大模型,免费且保密。

作为一个法律人,工作当中很想用大模型的时候,职业精神会把我们拦住,担心一些信息(即便不是保密信息)泄露,如果要处理掉敏感信息再用大模型吧,感觉更耽误时间,所以之前看到一些关于部署本地大模型的文章,就蠢蠢欲动,刚好认识的大佬实践完写了一篇,自己就跟着尝试了一下,从代码小白文科生的视角记录一下。

不过,先稍微理解一下后面用到的工具及本次没用到但未来可能用到的工具的一些概念。比如:

1. 虚拟环境(如venv),有点像一个办公室隔间,处理合同纠纷案时,你在A隔间,这里放的都是合同法司法解释、合同法相关判例汇编;处理家事案时,去到B隔间,这里放的都是婚姻家庭法相关判例汇编和规则汇编。两个隔间相互隔离,互不干扰。

2. Miniforge/Conda,类似于法律图书馆智能书架的管理员,他们把处理每个案件所需的书单独放到一个书架上(环境),保证律师或其助理不会拿错书(出现依赖冲突)。

3. Docker,就像是律师要出差去外地开庭所拎的公文包,里面包含所有你需要的法律规则、案例原文、你的电脑、U盘、甚至咖啡/红牛,到了法庭打开公文包直接就可以处理案件,无需任何其他材料。

4. Ollama,就像助理律师,他只要有专用的法律图书馆(本地环境),就可以查阅海量数据(调用模型训练数据)并给你反馈。

5. Open WebUI,就像是律所的前台兼秘书(网页界面),漂亮且友好地接待用户(即你)的需求。前台会把需求转交给你的助理律师,最后再帮助把结果交给客户。

这次我只用到前台秘书、助理律师和书架管理员。

安装Ollama

首先,招聘到我的助理律师,打开Ollama官网,出现一只可爱的羊驼,点击download,根据你的系统选择合适的下载包。

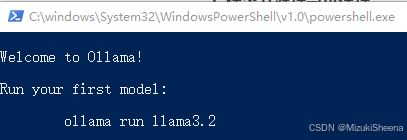

下载完成后双击安装,安装完成会自动弹出提示打开,打开后的界面如下:

如上图,可以输入如下代码查看版本:

ollama --version如下为返回结果:

![]()

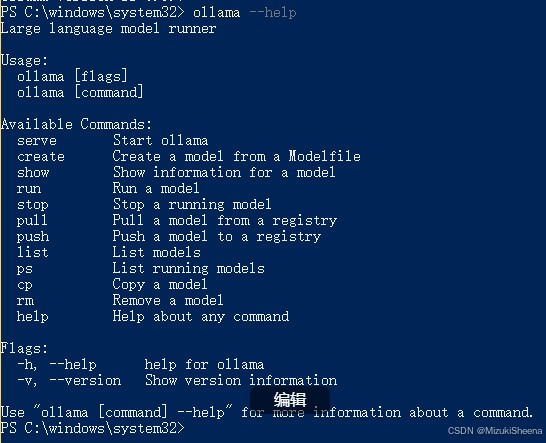

也可以输入如下代码查看如何使用ollama:

ollama --help如下为返回结果:

下载大模型

我不确定自己的电脑配置能用什么样的模型,所以我找到了配置页面,问了一下deepseek。

win系统的话,点击“开始”——“设置”——“系统”——“关于”,然后截图给deepseek,直接问对于附图所示配置而言,可以用什么样的大模型不会导致电脑太卡,deepseek给我的回复如下:

根据你的配置,推荐什么模型?

你的电脑配置(i7-1270P + 32GB内存)属于中高端,可以流畅运行以下模型:

7B参数模型(如

llama2-7b、mistral-7b):占用约4-8GB内存,速度快,适合日常聊天、写作。13B参数模型(如

llama2-13b):占用约12-16GB内存,回答质量更高,但速度稍慢。专用小模型(如

phi3、tinyllama):占用2-4GB内存,适合轻度任务。避免70B等超大模型,它们需要64GB以上内存,你的电脑可能无法流畅运行。

总结步骤

安装Ollama → 自动管理模型。

下载7B或13B模型 → 命令如

ollama run llama2-7b。安装Open WebUI → 获得可视化界面。

开始聊天 → 像用ChatGPT一样方便!

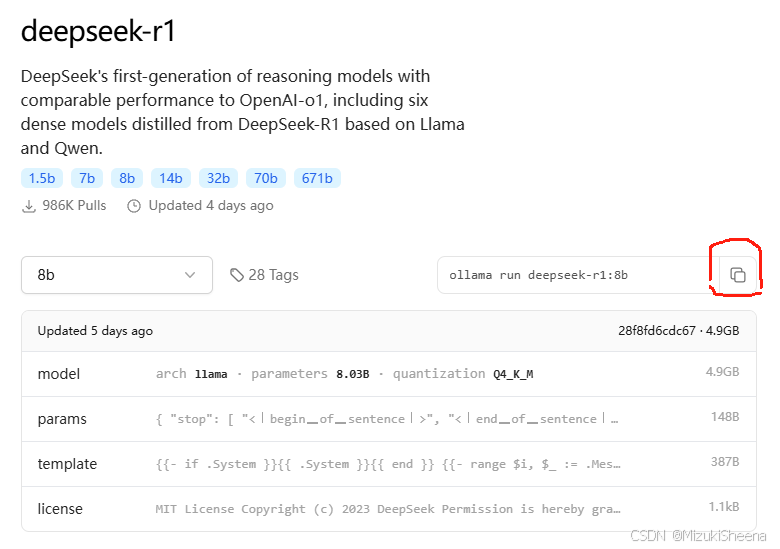

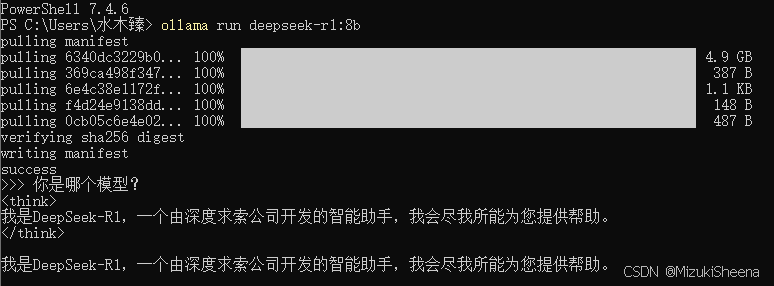

参考此回复,我决定选择deepseek 8B模型,打开Ollama模型下载,点击你想选择的模型,然后点击下图红框复制命令,在你的终端(cmd或者powershell)里输入后即自行下载。

下载完成会显示Suceess,并自动转为对话界面,可以在终端里直接和大模型对话啦。

其实到这里就完成了,只是这个律师助理太生硬了,只能进行文字互动。所以接下来考虑找个前台,让友好亲切美丽的小姐姐来和我对接,再把需求转给律师助理。

安装Miniforge,创建open WebUI环境

就像前面解释的,为了防止法律助理找错书,我们需要配备一个智能书架管理员(Miniforge),让他只在他需要的区域内活动。因此下载Miniforge(根据系统选择,有win,mac,linux)安装包,双击安装,安装过程中勾选“Add Miniforge3 to my PATH environment variable”,安装完成后,打开终端(cmd或powershell),输入以下命令验证是否安装成功:

conda --version如果返回了版本,则代表安装成功,接下来创建一个名为openwebui的独立python环境(python的版本根据你已安装的版本填写即可):

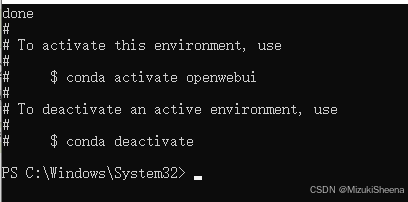

conda create -n openwebui python=3.12执行后会问你following packages would be download, proceed?输入yes即可,完成后会出现下图:

输入如下代码,启动这个名为openwebui的独立开发环境:

conda activate openwebui安装Open WebUI

最后一步就是安装Open WebUI了,打开终端(cmd或powershell)执行以下代码:

pip install open-webui其实我在执行过程中遇到了error,于是截图扔给deepseek问怎么回事,他给我的反馈如下:

问题原因

安装

chroma-hnewlib包时,需要编译 C/C++ 代码,但你的电脑缺少 Microsoft Visual C++ 编译工具。

解决方案

1. 安装 Microsoft Visual C++ 编译工具

下载工具:

访问微软官方下载页面:Microsoft C++ Build Tools

点击 “下载生成工具”。安装步骤:

运行安装程序后,勾选以下两项:

✅ “使用 C++ 的桌面开发”

✅ “Windows 10/11 SDK”点击安装,等待完成(可能需要 5-10 分钟)。

于是我依照此操作安装完成后,重新尝试安装Open WebUI,确实成功了。

启动Open WebUI

安装完成后,直接在终端启动Open WebUI,用以下代码:

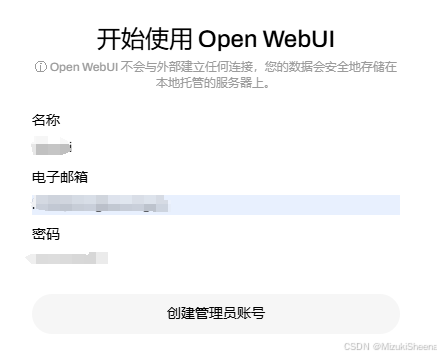

open-webui serve如果出现building the best open-source AI user interface并且运行停止,就是启动成功啦。由于服务默认端口是8080,启动成功后只要在浏览器地址栏输入http://localhost:8080,就会出现初始界面让你创建管理员账号:

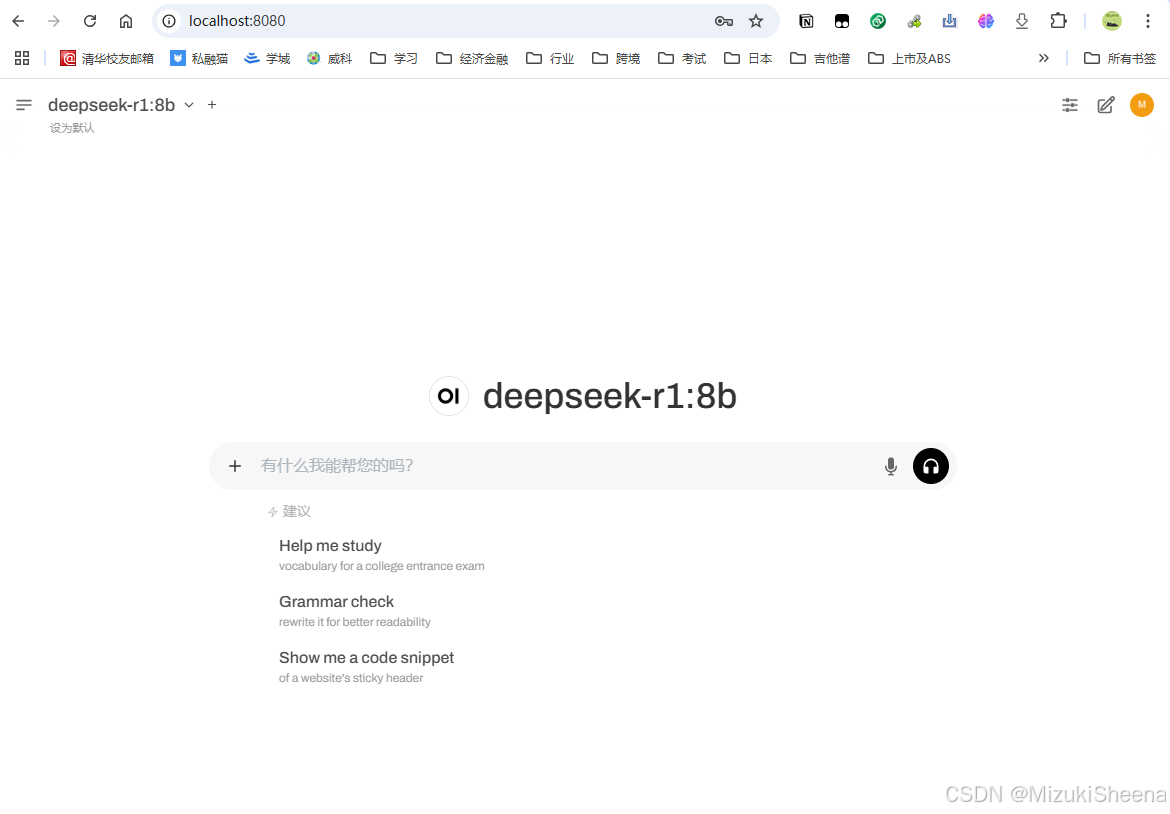

创建完成后,就可以像和网页版大模型对话一样,和部署在本地的大模型对话啦!

大功告成!✿✿ヽ(°▽°)ノ✿撒花!

未来的使用

以后每一次使用都是三步:

1. 打开终端,执行命令:

conda activate openwebui

open-webui serve2. 打开浏览器,输入http://localhost:8080,开始使用,使用过程中命令行窗口要保持开启哦!

3. 终止服务的话,在命令行窗口按ctrl+c就可以了。

更新BUG解决方案:

打开open webui上传文件时遇到报错,将报错情况发给deepseek后,指导我按如下方法,现已解决文件上传后报错的问题。

1. 检查文件上传目录

先看一下open webui安装包下是否有uploads这个文件夹,如无,需手动创建。

手动创建目录:

打开命令行。

输入以下命令:

mkdir D:\Miniforge\envs\openwebui\uploads确保目录有写入权限:

右键uploads文件夹 → 属性 → 安全 → 确保你的用户有“完全控制”权限。

2. 安装文件解析依赖

在

openwebui环境中安装依赖:

激活环境:

conda activate openwebui安装依赖库:

pip install unstructured python-magic python-magic-binWindows 额外步骤:

下载 magic.dll。

将其复制到

C:\Windows\System32。

3. 测试上传文件

启动 Open WebUI:

open-webui serve打开浏览器,访问

http://localhost:8080。上传一个简单的

.txt文件(内容为“Hello World”),看看是否还会报错。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)