DeepSeek-R1私有化大模型本地部署教程

本地部署DeepSeek-R1模型可以有效保护隐私数据不被泄露,并提供更稳定的服务。尤其在最近DeepSeek频繁遭受恶意攻击时,本地部署可避免服务中断,且无需依赖网络,灵活性更高。

本地部署DeepSeek-R1模型可以有效保护隐私数据不被泄露,并提供更稳定的服务。尤其在最近DeepSeek频繁遭受恶意攻击时,本地部署可避免服务中断,且无需依赖网络,灵活性更高。

推荐框架

推荐使用Ollama框架进行本地部署,其官网地址为:https://ollama.com

一、下载与安装步骤

1. 下载Ollama客户端

直接从Ollama官网下载客户端,建议复制文件地址以加速下载速度。

2. 使用GitHub加速站加速

访问加速站点链接:https://github.moeyy.xyz

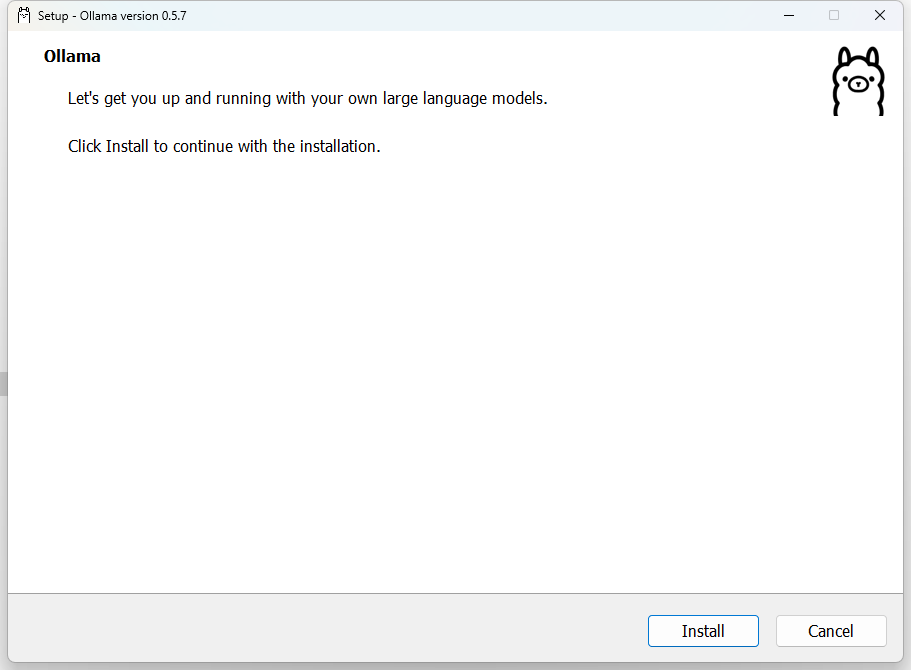

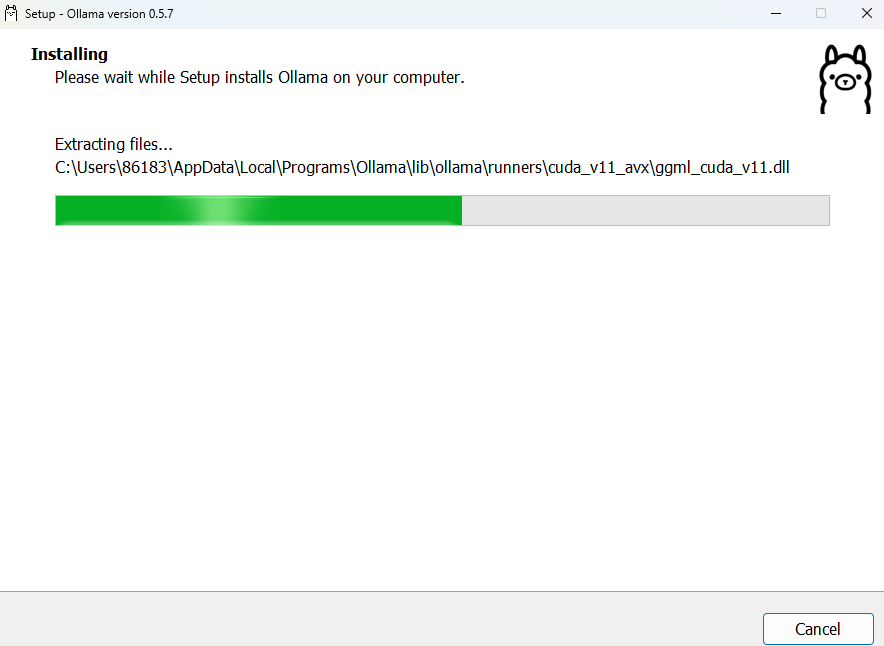

3. 安装客户端

以windows系统为例,双击此程序,点击install

![]()

4. 验证安装

安装完成后,按Windows+R键打开命令提示符(CMD),输入ollama回车,若显示安装成功信息则完成安装。

5. 访问DeepSeek官网

返回Ollama官网界面,选择并加载R1模型。

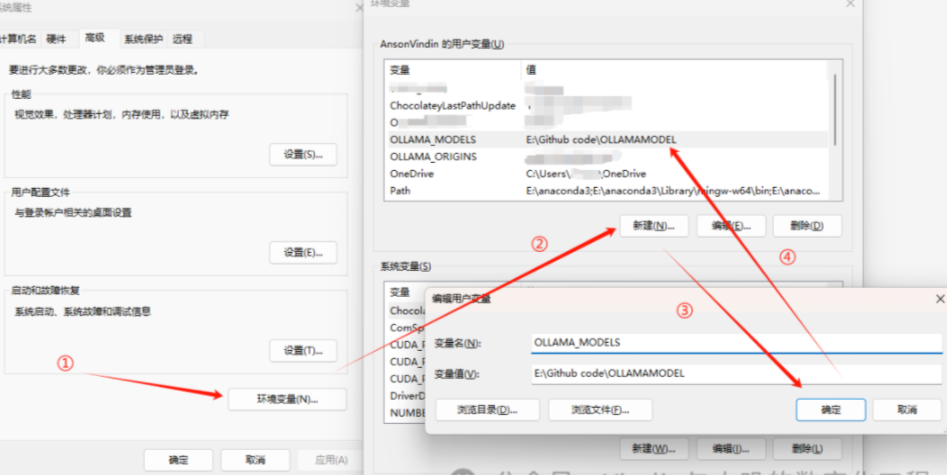

6. Ollama模型下载路径相关设置

如果不想你的C盘因为下载大模型(很多都是几G到十几G甚至几十G)被占用太多空间,那么可以做如下设置,如果无所谓可忽略本条操作:

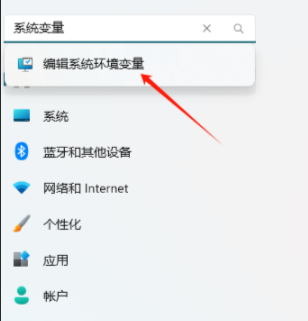

6.1 点击windows开始按钮或者直接点开开始菜单,选择设置,或者直接按下Windows快捷键win+i打开设置:

在搜索中输入系统变量

6.2在弹出的窗口中选择环境变量,然后在新窗口中的用户变量中点新建,在弹出的小窗口中输入

变量名:

OLLAMA_MODELS

变量值:

(你想要存放大语言模型的路径,举例说明:我想把模型存放在E盘Github code文件夹下的OLLAMAMODEL这个文件夹中,那么变量值就输入如下)

E:\Github code\OLLAMAMODEL

点击确定,这个新变量会出现在你的用户变量中。

至于OLLAMA_HOST这个变量,在某种程度上对于Docker部署前台是不利的,所以不建议设置。

6.3 试运行Ollama 提前说明:如果上述操作成功,但以下操作未成功,需要重启一下电脑。

6.4 Ollama试运行(非大模型运行)

对电脑的windows按钮点右键,选择终端管理员/终端,当然win+r输入cmd启动命令提示符亦可,但是建议使用管理员权限:

在打开的黑色窗口中输入ollama,然后回车,如果出现下面的内容则表示服务正常:

二、模型版本选择

671b版本模型体积较大,若显卡配置较低,建议选用7b或8b版本以满足日常需求。

下载模型文件

1. 打开CMD命令行

在安装完成后,按Windows+R键打开命令提示符(CMD),输入并回车确认安装成功。

2. 开始下载模型

返回命令行界面,复制官网指定的下载命令,粘贴执行开始下载所需模型文件。若下载卡住可尝试开启魔法网络模式。

下载完成后

执行以下命令查看下载的模型文件列表:

ollama list

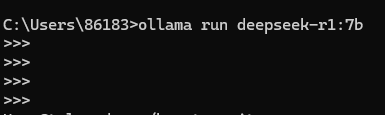

重启DeepSeek服务

1. 执行命令行操作

再次打开CMD,按Windows+R键调出命令提示符。

2. 启动DeepSeek服务

在命令行中输入以下命令并回车:

ollama run deepseek-r1:7b

三、测试本地部署效果

1. 提供问题测试

使用本地部署的DeepSeek-R1模型提出问题,观察其响应效果。

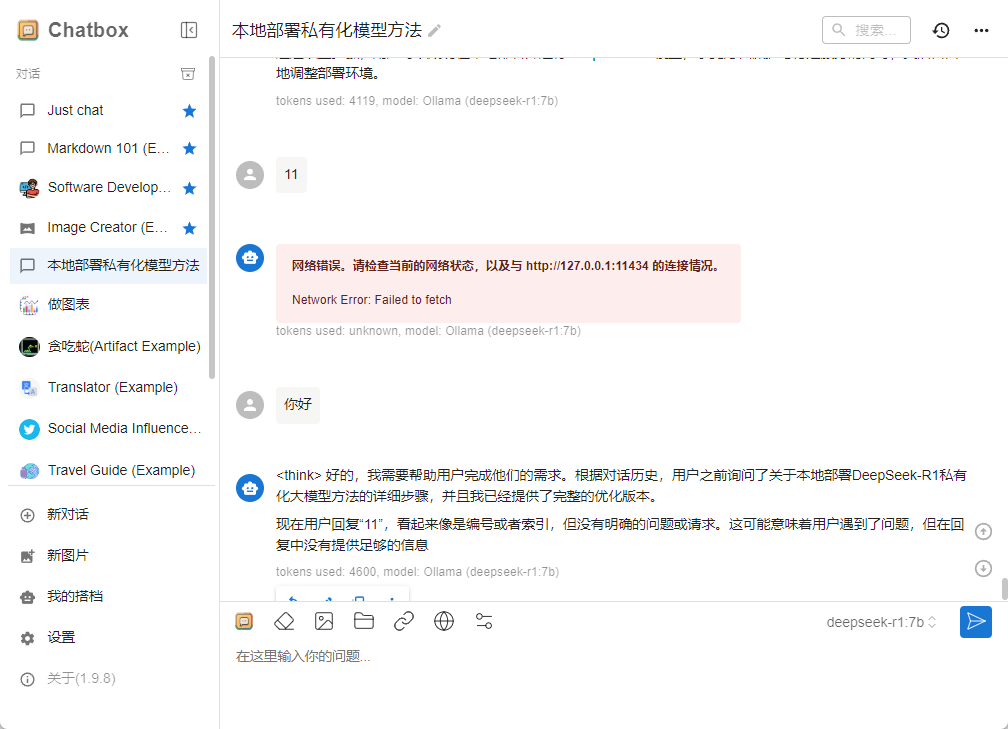

2. 方便的可视化安装

若体验想提升体验,可安装可视化工具 下载地址Chatbox AI官网:办公学习的AI好助手,全平台AI客户端,官方免费下载

设置模型

提问

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)