在docker容器中运行Ollama部署deepseek-r1大模型

访问http://主机IP:18080。

·

# 启动ollama容器

docker run -itd --gpus=all -v /app/ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama:0.5.12

# 进入容器

docker exec -it ollama bash

## 拉取大模型(7B为例)

ollama pull deepseek-r1:7b

## 修改监听地址和端口

export OLLAMA_HOST=0.0.0.0:11434

## 运行deepseek-r1:7b

ollama run deepseek-r1:7b

# 此时可以本地问答,也可以使用api发起请求

# 另外起open-webui容器服务

docker run -it --rm -p 18080:8080 \

-v /app/open-webui/data:/app/backend/data \

--add-host=host.docker.internal:host-gateway \

-e ENABLE_OLLAMA_API=False \

--name open-webui\

ghcr.io/open-webui/open-webui:main

api测试:

curl -X 'POST' \

'http://localhost:11434/v1/chat/completions' \

-H 'accept: application/json' \

-H 'Content-Type: application/json' \

-d '{

"messages": [

{

"content": "你是谁?",

"role": "user"

}

],

"model": "deepseek-r1:7b",

"stream": true

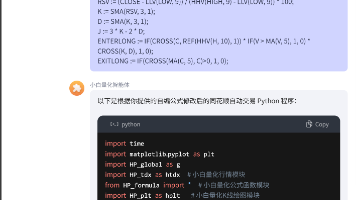

}'open-webui接入ollama api

访问http://主机IP:18080

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)