一起简单说过itellm 支持多种模式的大模型运行,有proxy 模式(可以proxy 模型以及包含api服务的模型接口),也有直接通过python 代码进行访问的,以下是对于ollama 模型的一个简单运行试用

python代码模式

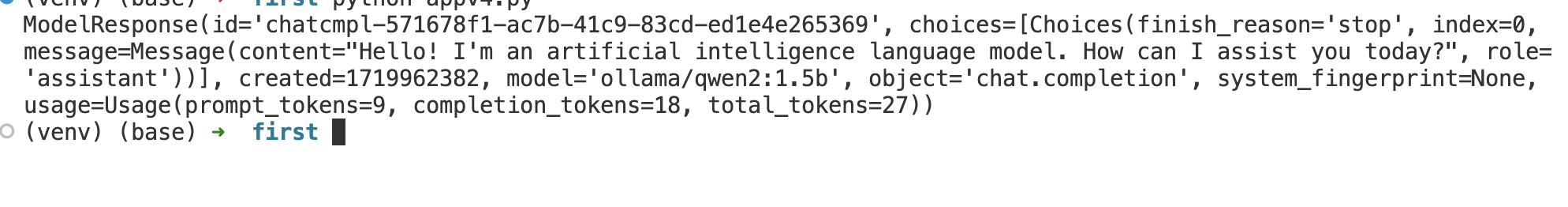

- appv4.py

此模式litellm 会自己进行

- 效果

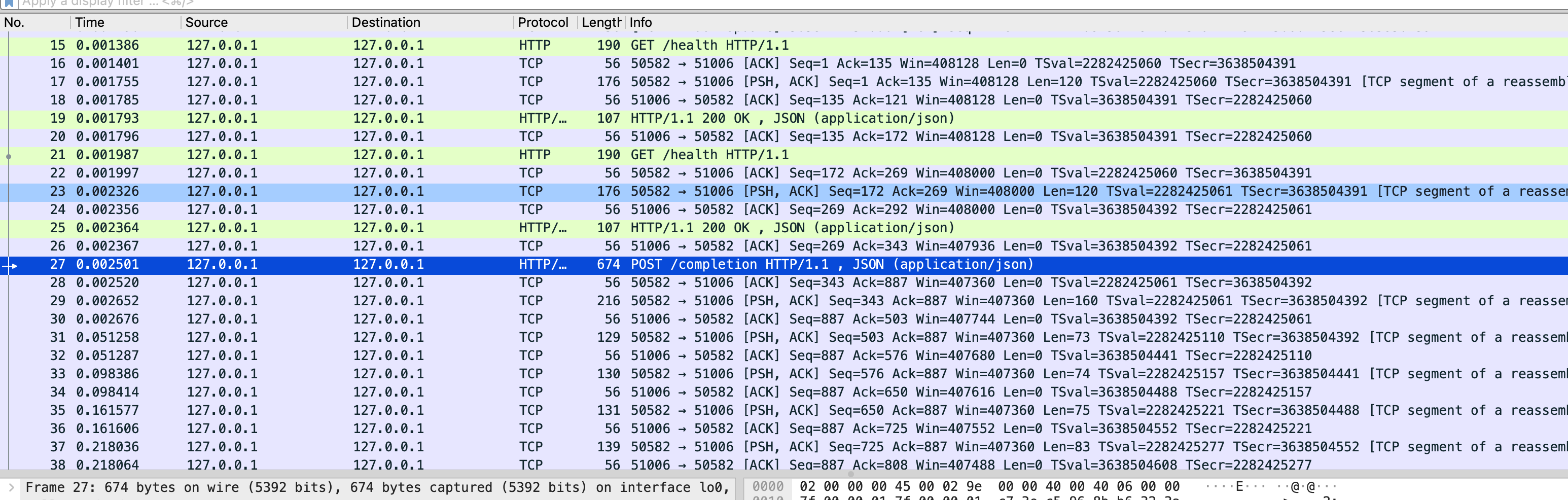

实际api 调用( 通过wireshark 分析的)

说明

litellm ollama python 代码模型的运行也是通过基于ollama 提供的接口调用,只是对于model 格式上有一个比较明确的定义, ollama/qwen2:1.5b 其中ollama 是必须的,属于provider 名称,后边是实际模型的名称

参考资料

https://docs.litellm.ai/docs/proxy/quick_start

https://github.com/BerriAI/litellm

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)