从零开始Autogenstudio配合ollama安装本地大模型

可以输入命令行:ollama list 查看已安装的大模型。2、切换环境:完成环境创建后,切换至新环境:命令:conda activate autogen_studio。2、安装本地大模型 打开Anaconda Prompt 输入命令行:ollama run (大模型名称)切换到刚刚打开的Anaconda Prompt中,粘贴刚刚复制的命令,ollama会自动下载安装大模型。进入官网点击右上方Mo

Autogenstudio配合ollama安装本地大模型

一、下载安装Autogenstudio

1、下载安装Anaconda3 官网:Anaconda

2、安装Autogenstudioconda

1、安装python环境:打开Anaconda Prompt 输入命令行:create -n autogen_studio python=3.11

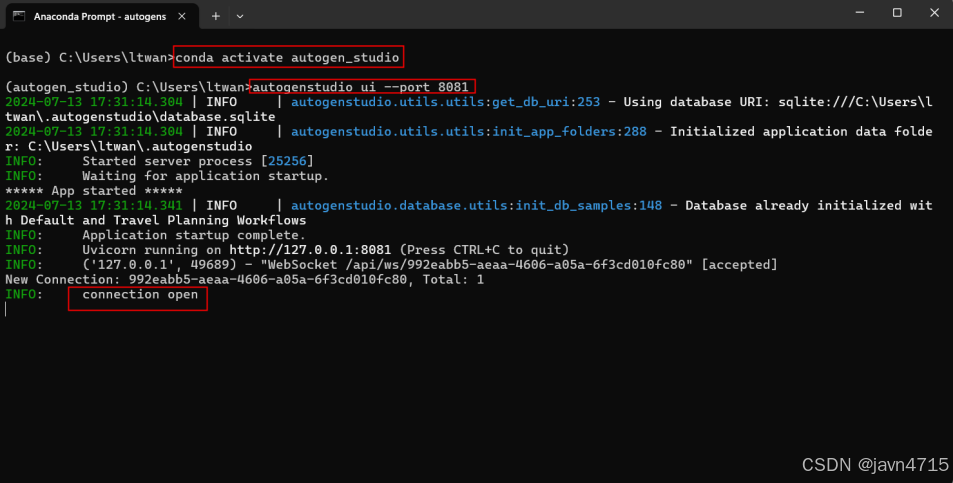

2、切换环境:完成环境创建后,切换至新环境:命令:conda activate autogen_studio

3、打开Autogenstudio在新环境中输入命令行:autogenstudio ui --port 8081

4、Autogenstudio可视化操作:打开浏览器:http://127.0.0.1:8081/

二、安装ollama

1、安装ollama 官网:Ollama 下载对应的版本并安装

2、安装本地大模型 打开Anaconda Prompt 输入命令行:ollama run (大模型名称)

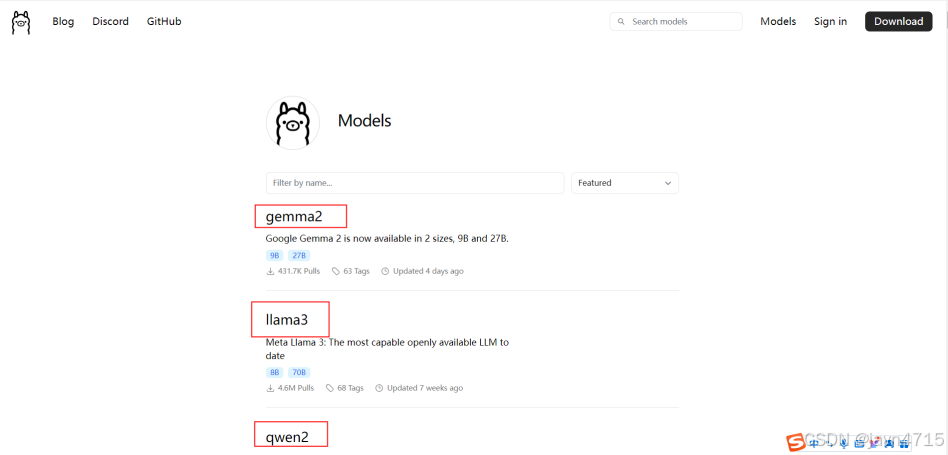

进入官网点击右上方Models,进入大模型列表,选择需要安装的大模型

选择对应版本:根据个人机器配置选择对应版本,建议不要选择太大的版本。

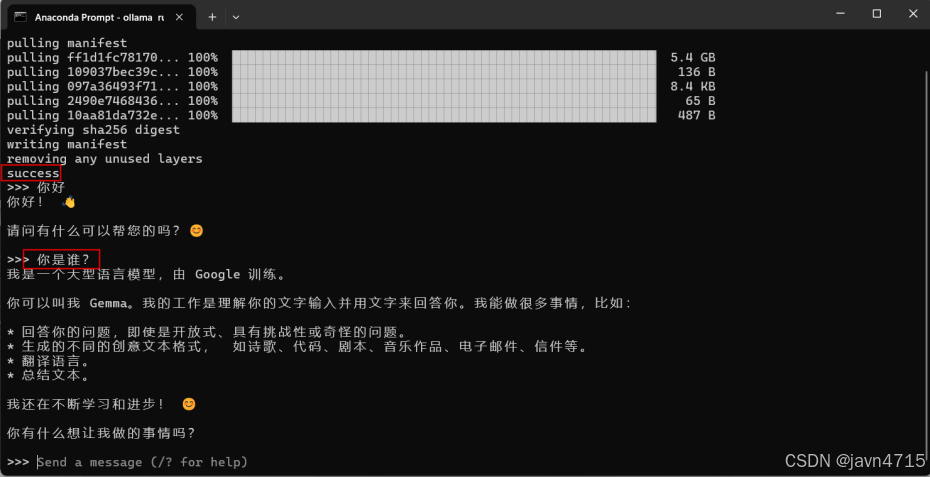

这里选择 gemma2 9B为例。点击右侧复制命令。

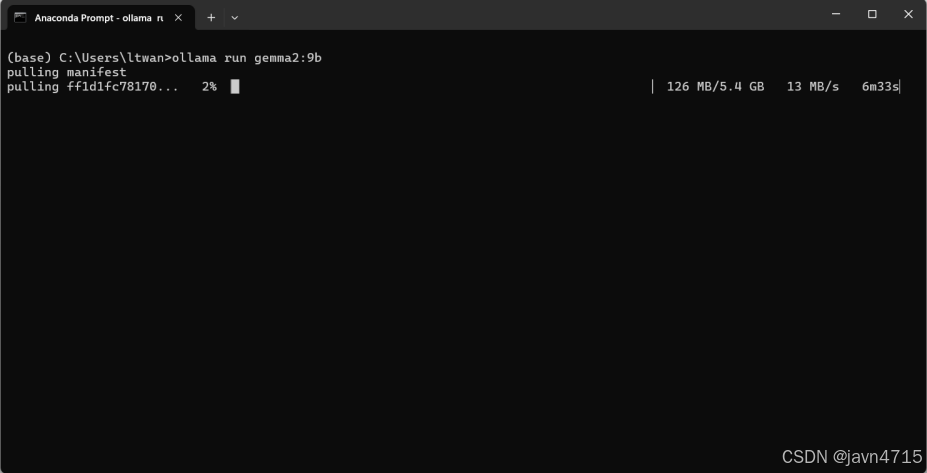

切换到刚刚打开的Anaconda Prompt中,粘贴刚刚复制的命令,ollama会自动下载安装大模型

如图等待下载安装。

看到success说明已经安装成功了。可以与大模型对话测试一下。

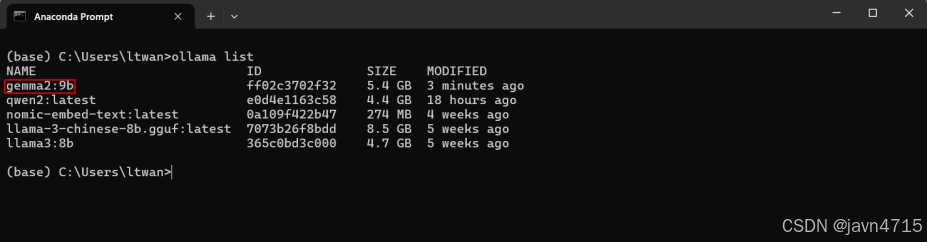

可以输入命令行:ollama list 查看已安装的大模型。后期再需要运行大模型直接输入:ollama run gemma2:9b 即可。

ollama 启动大模型后,端口号:默认端口:http://localhost:11434/v1

三、安装Litellm轻量快速部署大模型。

1、Anaconda Prompt中输入命令行:conda activate autogen_studio (切换环境);

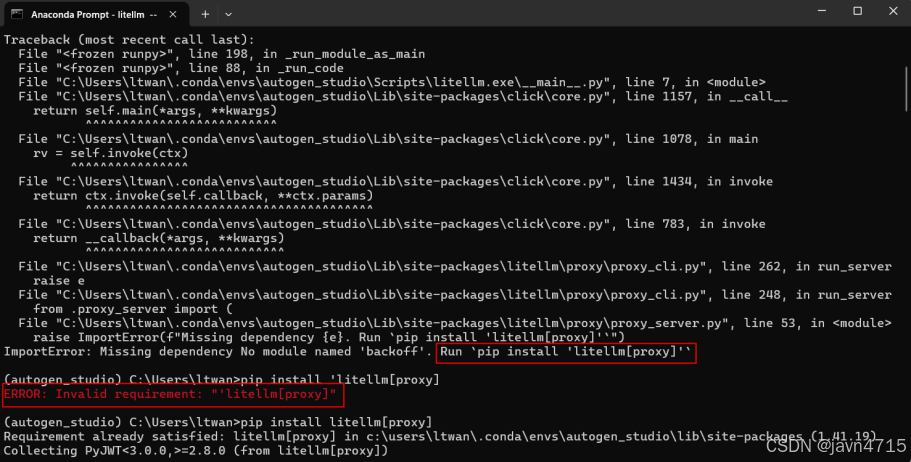

然后输入命令行:pip install litellm 进行安装

这里出现错误需要安装litellm[proxy], 我们继续输入命令行 pip install litellm[proxy] 进行安装。

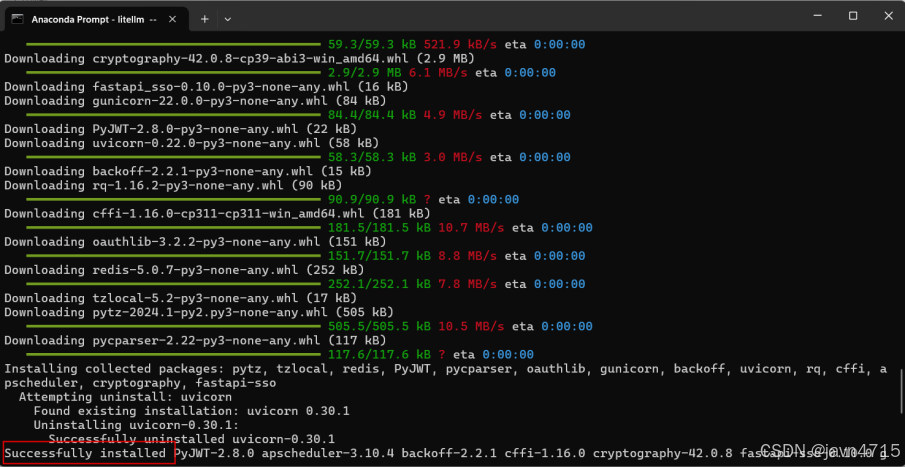

如图经过等待显示Successfully installde 说明已经安装完毕

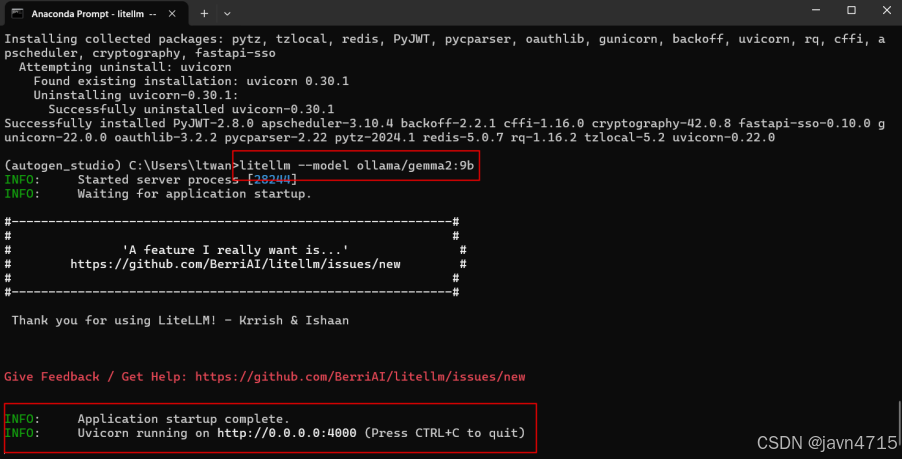

然后输入命令行:litellm --model ollama/gemma2:9b 对已经启动的大模型进行部署。

如图说是已经部署完毕。

四、在Autogenstudio中使用本地大模型

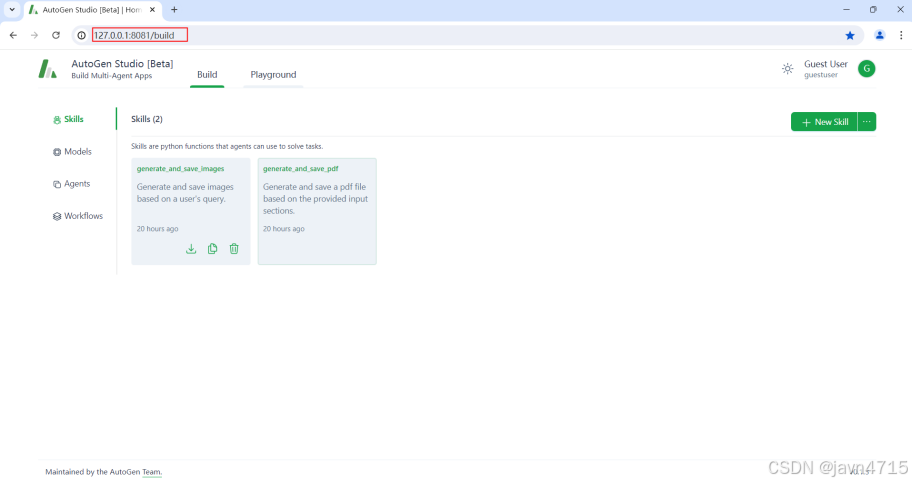

打开Autogenstudio 打开浏览器:http://127.0.0.1:8081/

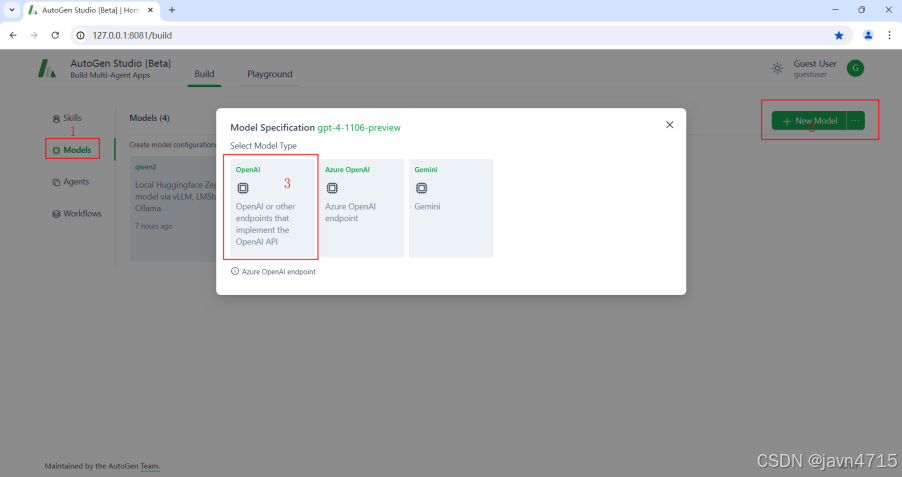

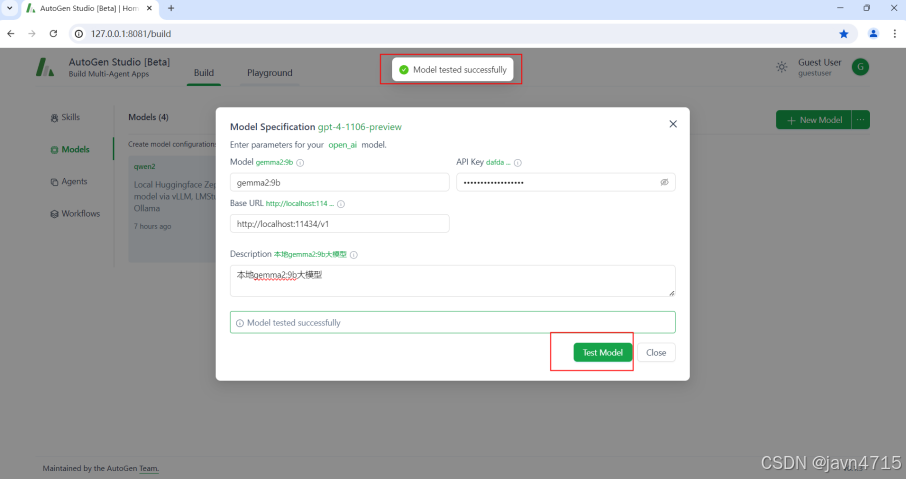

添加本地大模型一次点击:页面左侧的Models,页面右侧 +New Model,然后点击弹窗中第一个标签“OpenAI”如下图:

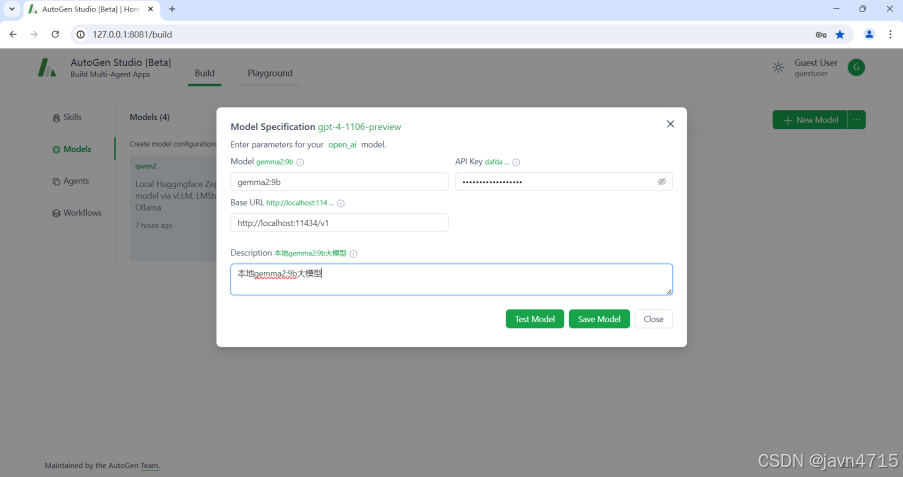

开始配置本地大模型如下图:

第一个参数: Model:gemma2:9b (填写启动的本地大模型名称 必须一致);

第二参数: API Key:随意填写,接入本地模型不需要API Key ;

第三个参数: Base URL:http://localhost:11434/v1 (ollama 启动本地大模型的默认地址)

点击Save Models 保存

测试大模型是否链接成功:点击 Test Model 测试。

如图显示: Model tested successfully 恭喜你已经配置好了本地大模型。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)