从0到1用Python构建AI智能体的超详细开发指南

从0到1用Python构建AI智能体的超详细开发指南

·

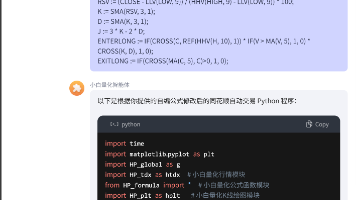

从0到1用Python构建AI智能体的超详细开发指南,涵盖核心模块、代码示例及避坑策略,结合2025年最新技术实践:

一、环境准备与工具选型

1. 基础环境

# 创建虚拟环境

python -m venv ai_agent_env

source ai_agent_env/bin/activate # Linux/Mac

ai_agent_env\Scripts\activate # Windows

# 安装核心依赖

pip install langchain openai python-dotenv gradio

- LangChain:用于构建智能体工作流(如工具调用、记忆管理)

- Gradio:快速搭建交互界面

2. 大模型接入

# .env文件配置API密钥

OPENAI_API_KEY="sk-your-key"

# 或使用国产模型(如百度千帆)

QIANFAN_AK="your-ak"

QIANFAN_SK="your-sk"

# 初始化模型(示例:OpenAI)

from langchain_openai import ChatOpenAI

llm = ChatOpenAI(model="gpt-4o", temperature=0.3)

二、核心模块开发

1. 感知-决策-行动循环

from langchain.agents import Tool, AgentExecutor

from langchain.agents import create_react_agent

# 定义工具(示例:天气查询)

def get_weather(city: str) -> str:

return f"{city}天气:晴,25℃"

tools = [

Tool(

name="WeatherCheck",

func=get_weather,

description="查询城市天气"

)

]

# 构建智能体

prompt_template = """你是一个助手,根据用户输入选择工具并执行:

工具列表:{tools}

问题:{input}

请逐步思考并给出最终答案。"""

agent = create_react_agent(llm, tools, prompt_template)

agent_executor = AgentExecutor(agent=agent, tools=tools, verbose=True)

# 测试执行

response = agent_executor.invoke({"input": "北京现在天气如何?"})

print(response["output"]) # 输出:北京天气:晴,25℃

2. 记忆管理

from langchain.memory import ConversationBufferMemory

memory = ConversationBufferMemory(memory_key="chat_history")

agent_executor = AgentExecutor(

agent=agent,

tools=tools,

memory=memory,

verbose=True

)

# 多轮对话测试

agent_executor.invoke({"input": "北京天气适合穿什么?"}) # 会引用历史记录

三、进阶功能实现

1. 多模态处理

# 图像处理工具示例

from PIL import Image

def image_analysis(img_path: str) -> str:

img = Image.open(img_path)

return f"检测到{img.size}像素的图片,包含猫和沙发"

tools.append(

Tool(

name="ImageAnalyzer",

func=image_analysis,

description="分析图片内容"

)

)

# 多模态调用示例

response = agent_executor.invoke({"input": "分析photo.jpg的内容"})

2. 自主任务分解

# 使用LangChain的Plan-and-Execute模式

from langchain_experimental.plan_and_execute import PlanAndExecute

planner = PlanAndExecute(

planner=llm,

executor=agent_executor,

verbose=True

)

planner.run("请先查北京天气,再推荐旅游景点")

四、部署与优化

1. Web界面开发

import gradio as gr

def chat_interface(message, history):

response = agent_executor.invoke({"input": message})

return response["output"]

demo = gr.ChatInterface(chat_interface)

demo.launch(server_name="0.0.0.0", server_port=7860)

2. 性能优化技巧

- 缓存策略:对高频查询结果缓存(Redis/Memcached)

- 流式响应:减少用户等待感知

# 流式输出实现

for chunk in agent_executor.stream({"input": question}):

print(chunk.get("output", ""), end="", flush=True)

五、避坑指南

-

状态同步问题

- 使用

ConversationBufferWindowMemory限制记忆长度,避免内存溢出 - 对敏感操作添加确认机制(如"确定要删除文件吗?")

- 使用

-

安全防护

- 输入过滤:使用

langchain_core.output_parsers验证输出格式 - 权限控制:对不同工具设置访问权限

- 输入过滤:使用

-

调试技巧

- 启用LangSmith监控执行过程

- 使用

langchain.debug = True查看详细决策日志

六、典型应用场景

| 场景 | 技术方案 | 工具示例 |

|---|---|---|

| 智能客服 | RAG+意图识别 | 知识库检索+工单系统对接 |

| 自动化办公 | 文档解析+流程编排 | PDF解析器+邮件自动回复 |

| 游戏NPC控制 | 状态机+行为树 | Unity API集成+路径规划 |

下一步建议:

- 在GitHub搜索

openagent-framework获取更多模板项目 - 使用

LangGraph实现复杂多智能体协作 - 通过

HuggingFace集成开源小模型降低成本

本方案综合了LangChain的模块化设计、多智能体协作、以及轻量级部署等最新实践,如需完整代码示例可进一步说明具体应用场景。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)