斯坦福&哈佛医学院MMedAgent:多模态医疗AI智能体,模型、数据、代码均开源

多模态大型语言模型(MLLMs)尽管取得了一些成功,但其通用性有限,常常在与专用模型的对比中显得不足。最近,基于LLM的智能体被开发出来以解决这些问题,通过根据用户输入选择合适的专用模型作为工具。然而,这些进步在医学领域尚未被广泛探讨。为了填补这一空白,本文首次引入了一种明确为医学领域设计的智能体,称为多模态医学智能体(MMedAgent)。为此,我们策划了一个包括六种医疗工具和在五种模态中解决七

论文:https://arxiv.org/html/2407.02483v2

代码:https://github.com/Wangyixinxin/MMedAgent

摘要

多模态大型语言模型(MLLMs)尽管取得了一些成功,但其通用性有限,常常在与专用模型的对比中显得不足。最近,基于LLM的智能体被开发出来以解决这些问题,通过根据用户输入选择合适的专用模型作为工具。然而,这些进步在医学领域尚未被广泛探讨。为了填补这一空白,本文首次引入了一种明确为医学领域设计的智能体,称为多模态医学智能体(MMedAgent)。为此,我们策划了一个包括六种医疗工具和在五种模态中解决七个任务的数据集,从而使智能体能够为给定任务选择最合适的工具。全面的实验表明,MMedAgent在性能上优于当前最新的开源方法,甚至超过了闭源模型GPT-4o。此外,MMedAgent在更新和整合新医疗工具方面表现出色。

MMedAgent

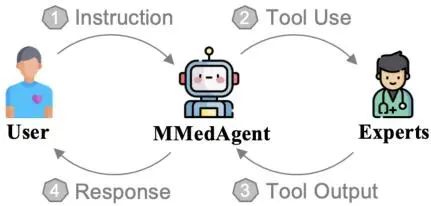

多模态医学智能体(MMedAgent)是一个基于大规模语言模型(MLLM)的系统,旨在通过整合各种开源医疗模型来无缝管理多种医疗任务。MMedAgent由两个组件组成:

(1)一个经过指令调优的多模态LLM作用为动作规划器和结果汇总器;

(2)一套适用于智能体的医疗工具,针对医学领域中的特定任务。

首先介绍MMedAgent的基本工作流程,然后描述为训练多模态LLM作为动作规划器而创建的指令调优数据集,接下来详述MMedAgent中包含的医疗任务和相应工具。

工作流程

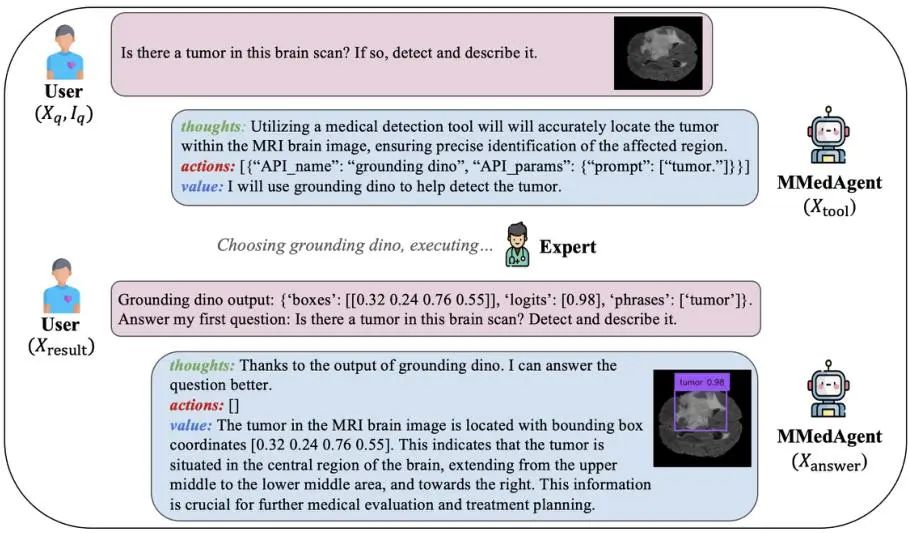

MMedAgent旨在学习利用广泛的多模态医疗工具扩展MLLM的能力,以分析和完成各种医疗任务。用户提供指令和医用图像,MLLM作为行为规划器,理解并生成格式化的指令以调用特定工具。工具执行后,MLLM将输出与用户的初始图像和指令整合,生成最终回答。通过自回归目标训练智能体生成的序列,确保模型使用正确的工具并根据工具结果回答问题。

指令调优

为了确保MMedAgent同时作为动作规划器和结果汇总器,我们采用了统一的对话格式。具体来说,当收到用户输入后,MMedAgent会在其输出中生成三个组件:

(1)思想,确定MMedAgent能否独立解决用户的指令,还是需要外部工具;

(2)动作,列出执行思想所需的API调用清单,包括API名称和参数;

(3)价值,提供来自MLLM的自然语言回应。

第一轮中,它指示所选工具;第二轮中,它表示最终输出,解决用户的初始请求。我们通过一对一学习方式查询GPT-4o构建指令数据。

医学任务与工具

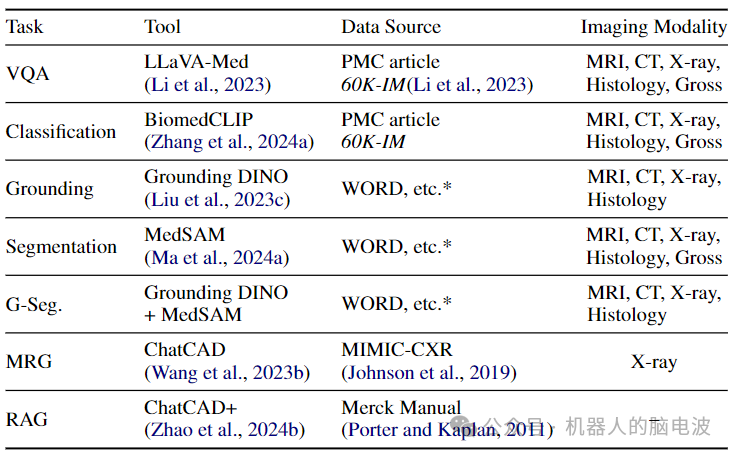

MMedAgent具有访问多种工具的能力,并能扩展以处理各种任务。我们集成了六种工具,涵盖了医学领域中的七个代表性任务,包括

(1)定位,

(2)使用边界框提示的分割(B-Seg),

(3)使用文本提示的分割(G-Seg),

(4)医学影像分类,

(5)医学报告生成(MRG),

(6)检索增强生成(RAG)

(7)视觉问答(VQA)。

对于VQA任务,由于MMedAgent的骨干LLaVA-Med原本支持该任务,因此不需要额外的工具。每个工具都作为一个专家,表现出在各种医学成像模态中执行特定任务的卓越能力。

定位

定位,即检测,旨在通过生成包含对象的边界框坐标来识别并定位输入图像中的特定对象。为了能够同时处理来自不同模态的图像,提出了一种面向医学领域的通用定位工具。选择对开集对象检测器Grounding DINO进行了微调,以适应医学成像领域。首先收集了多个医学图像分割数据集,这些数据集涵盖了不同的模态,并通过提取每个对象的最小外矩形,将这些分割掩码转换为边界框的坐标。

其他任务

B-Seg涉及在提供覆盖感兴趣区域(ROIs)的边界框时识别并勾画出图像的感兴趣区域。选择MedSAM作为工具。用户需要提供边界框的位置,MedSAM可以直接应用以获取ROI掩码。G-Seg结合了定位工具与SAM,旨在处理更常见的场景。当用户仅指定特定对象进行分割时,先激活微调后的定位工具以定位该对象并提供其位置。分类任务旨在识别医学图像中最合适的类别,通过BiomedCLIP进行零样本和细粒度分类。MRG任务涉及从提供的医学信息或成像中生成准确的医学报告,使用ChatCAD进行胸部X光图像的报告生成。RAG通过来自外部数据源获取最相关的信息,选择ChatCAD+实现医疗检索过程。

实验设置

MMedAgent使用LLaVA-Med 60K-IM进行初始化,并通过LoRA进行15个epoch的调优。训练在两块80G的NVIDIA A100 GPUs上进行,历时约72小时。实验使用AdamW优化器和峰值为2e-4的余弦学习率。生成了48K条指令调优数据,包括从60K内联提及中派生的15K条增强VQA指令。

实验结果

对MMedAgent进行实验以回答三个研究问题:

(1)MMedAgent在处理跨多模态的多种医学任务上的表现如何?

(2)经过指令调优的MMedAgent在开放式生物医学对话中是否表现出更优越的性能?

(3)MMedAgent调用工具或整合新工具的效率如何?

评估标准

为评估MMedAgent在不同复杂医学任务上的性能,创建了包含70个不同问题的评估数据集,包含来自Merck Manual的10个概念和不同任务的60张未见图像。预期输出来自GPT-4o,并与其他基准进行比较。所有输出都将由GPT-4评估,并根据它们的帮助性、相关性、准确性和详细程度进行打分。

实验结果

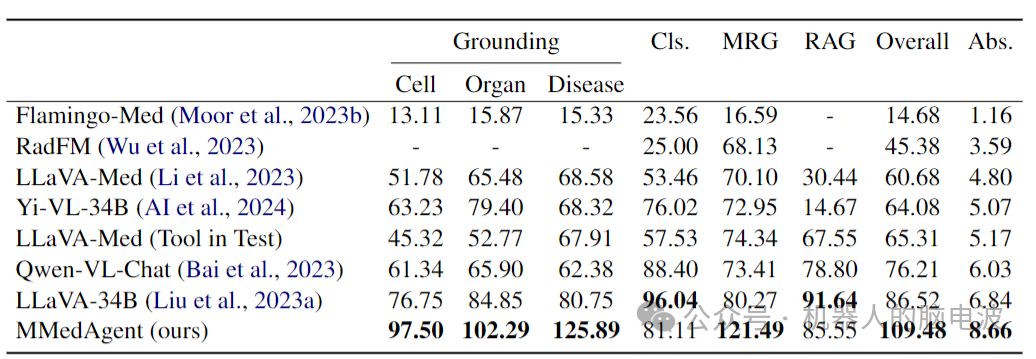

实验结果显示,MMedAgent在各种任务上明显优于所有其他基线。注意到,在器官定位、疾病定位和MRG任务上的得分超过100%,表明MMedAgent在这些任务上超越了GPT-4o。这些结果突出了MMedAgent在跨多种模态处理不同医学任务方面的卓越效率。

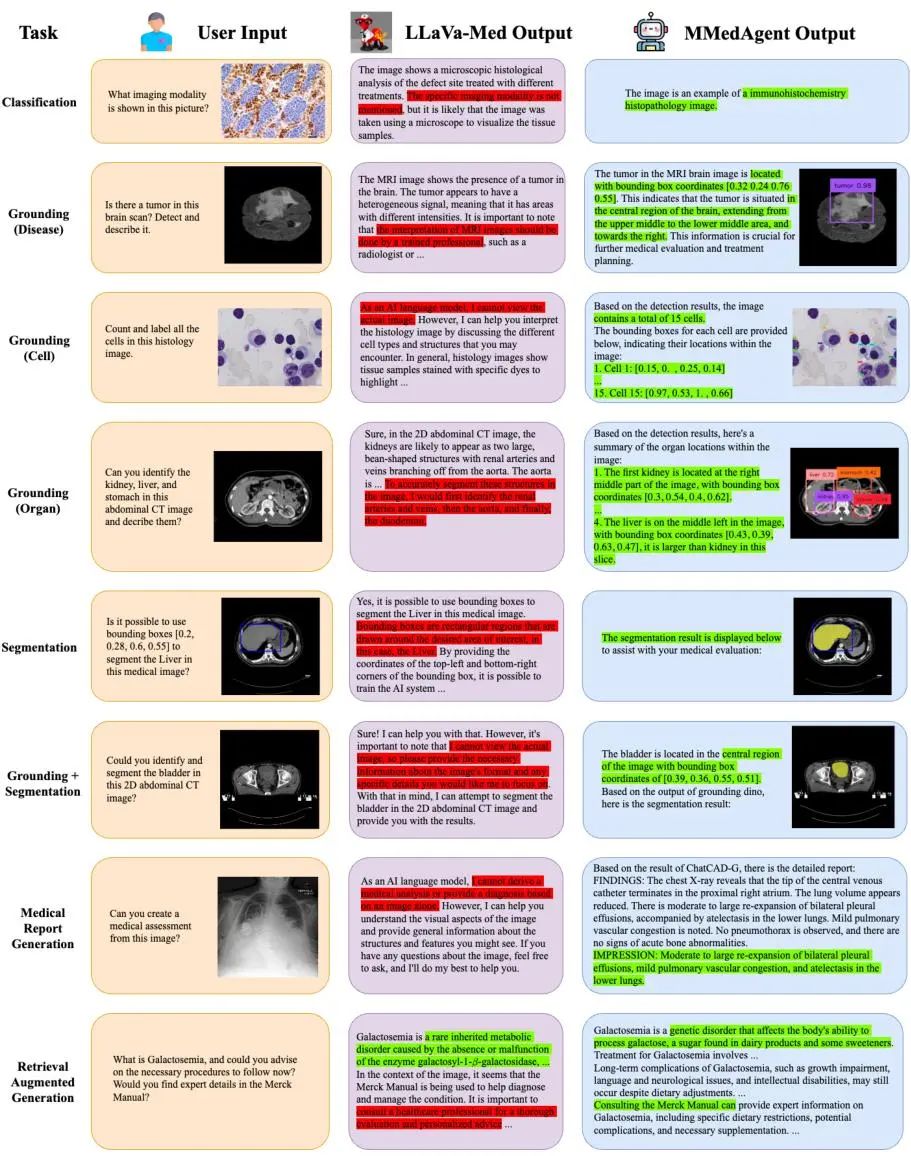

案例研究

在描述LLaVA-Med与MMedAgent的详细对比中,MMedAgent通过激活合适的工具,有效回答了问题,并生成了准确的响应,而LLaVA-Med则未能在指定任务中生成可视化结果。当遇到基于语言生成的任务时,LLaVA-Med无法提供图像的深入分析,而MMedAgent则利用专为这些任务设计的工具生成了更直接和准确的响应。

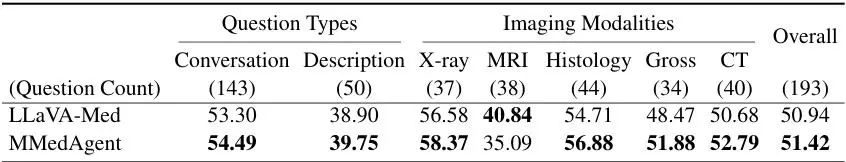

医学视觉问答

在实施VQA任务时,MMedAgent可以依靠其骨干LLaVA-Med,还可以通过利用其他VQA专家进行进一步增强。经过工具学习数据集的指令调优后,MMedAgent在不同类型的问题上表现更佳。

通过这些实验证明,MMedAgent不仅超越了多个最新的医学多模态语言模型,还展示了其在开放式医学对话中的有效性和准确性。

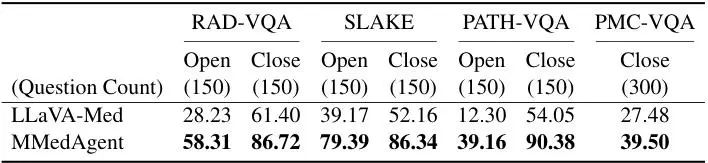

VQA基准测试

评估了MMedAgent在四个VQA基准(包括VQA-RAD、SLAKE、PMC-VQA和PATH-VQA)上的性能。为每个数据集构建指令调优数据,并使用新增的VQA工具微调模型。随机选取4K图文对作为训练集,300对用于评估。具体来说,每个VQA-RAD、PATH-VQA和SLAKE数据集包含150个开放集样本和150个封闭集样本,而PMC-VQA则由300个封闭的多选问题组成。结果表明,MMedAgent在所有VQA基准中均显著优于LLaVA-Med。

工具使用

MMedAgent超越其他模型的表现依赖于对用户输入的准确理解和激活正确工具的能力。在训练了15个epoch之后,工具选择的准确率达到100%,展示了其在不出错前提下选择适当工具的能力。MMedAgent的另一个重要功能是适应新工具的能力。考虑到两种情况:第一,当一个优于已存在任务的工具出现时,可以无缝地将旧工具的API名称替换为新工具,而无需重新训练。第二,为扩展到新任务,只需为此特定任务生成一小部分指令调优数据并进行相应的微调,而不需要从头开始重新训练。为了验证这一能力,模拟了一种名为“Pseudo Tool”的新工具,生成额外的5K指令调优数据,并创建30个未见的多样化问题进行评估。在一块80G A100 GPU上以较小的学习率进行微调。在2K步内,新工具选择的准确率达到100%,并且选择旧工具的性能没有受损。

结论

MMedAgent是首个多模态医学AI智能体,能够无缝利用多种医疗工具处理跨不同成像模态的宽泛医学任务。通过创建的指令调优数据集,MMedAgent学习调用各种医疗工具并汇总工具的结果。全面的实验展示其在许多医学任务中不仅优于现有的基准模型,甚至超越了GPT-4o。此外,MMedAgent在高效整合新工具的同时,仍然保持激活先前学习工具的能力。

局限性

目前的研究局限于在五种模态中处理七个任务。由于需要广泛的领域知识,需纳入更多专用工具,而MMedAgent的可扩展性允许在未来包括更强大的工具。此外,医学领域中的更多通用LLM可能成为增强MMedAgent的更强大基础。

最后的最后

感谢你们的阅读和喜欢,我收藏了很多技术干货,可以共享给喜欢我文章的朋友们,如果你肯花时间沉下心去学习,它们一定能帮到你。

因为这个行业不同于其他行业,知识体系实在是过于庞大,知识更新也非常快。作为一个普通人,无法全部学完,所以我们在提升技术的时候,首先需要明确一个目标,然后制定好完整的计划,同时找到好的学习方法,这样才能更快的提升自己。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

大模型知识脑图

为了成为更好的 AI大模型 开发者,这里为大家提供了总的路线图。它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

经典书籍阅读

阅读AI大模型经典书籍可以帮助读者提高技术水平,开拓视野,掌握核心技术,提高解决问题的能力,同时也可以借鉴他人的经验。对于想要深入学习AI大模型开发的读者来说,阅读经典书籍是非常有必要的。

实战案例

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

面试资料

我们学习AI大模型必然是想找到高薪的工作,下面这些面试题都是总结当前最新、最热、最高频的面试题,并且每道题都有详细的答案,面试前刷完这套面试题资料,小小offer,不在话下

640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

更多推荐

已为社区贡献48条内容

已为社区贡献48条内容

所有评论(0)